ChatGPT przekazuje fałszywe informacje

Pewien Norweg złożył skargę po tym, jak ChatGPT fałszywie poinformował go, że mężczyzna zabił swoich dwóch synów i został skazany na 21 lat więzienia.

Zdjęcie: pochodzące z mediów społecznościowych

Arve Hjalmar Holmen skontaktował się z Norweskim Urzędem Ochrony Danych i zażądał ukarania twórcy chatbota, OpenAI, grzywną.

To najnowszy przykład tak zwanych „halucynacji”, w których systemy sztucznej inteligencji (AI) wymyślają informacje i przedstawiają je jako fakty.

Pan Holmen twierdzi, że ta zmyśłona informacja jest dla niego bardzo szkodliwa.

„Niektórzy uważają, że nie ma dymu bez ognia — najbardziej przeraża mnie fakt, że ktoś może przeczytać ten tekst i uwierzyć w to, że jest prawdziwy,” — powiedział.

Skontaktowano się z OpenAI w celu uzyskania komentarza. Pan Holmen otrzymał fałszywe informacje po tym, jak użył ChatGPT do wyszukania: „Kim jest Arve Hjalmar Holmen?”.

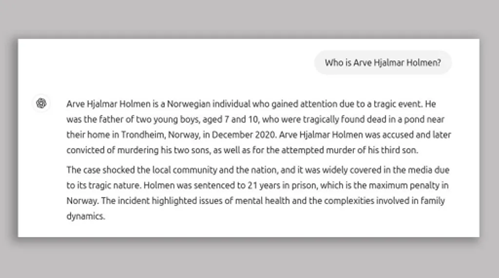

Oto odpowiedź, którą otrzymał od ChatGPT: „Arve Hjalmar Holmen to Norweg, który zwrócił na siebie uwagę dzięki tragicznemu wydarzeniu.

Był ojcem dwóch małych chłopców w wieku 7 i 10 lat, którzy zostali znalezieni martwi w stawie niedaleko ich domu w Trondheim (Norwegia) w grudniu 2020 r.”.

Pan Holmen powiedział, że chatbot mniej więcej poprawnie obliczył różnicę w wieku jego synów, co sugeruje że miał pewne dokładne informacje na jego temat.

Noyb - grupa zajmująca się prawami cyfrowymi, która złożyła skargę w jego imieniu - twierdzi, że odpowiedź udzielona przez ChatGPT jest zniesławiająca i narusza europejskie przepisy dotyczące dokładności oraz ochrony danych osobowych.

Organizacja stwierdziła w swojej skardze, że pan Holmen „nigdy nie został oskarżony ani skazany za żadne przestępstwo i jest przykładnym obywatelem”.

ChatGPT zawiera zastrzeżenie, które mówi: „ChatGPT może popełniać błędy.

Sprawdź ważne informacje”. Noyb jest zdania, że to niewystarczające.

„Nie możesz po prostu rozpowszechniać fałszywych informacji i na końcu dodać małego zastrzeżenia, że wszystko, co powiedziałeś, może po prostu nie być prawdą” — powiedział prawnik Noyba, Joakim Söderberg.

Zdjęcie: Noyb European Center for Digital Rights

Fantasmagorie są jednym z głównych problemów, jakie próbują rozwiązać informatycy w zakresie generatywnej sztucznej inteligencji.

Występują, gdy chatboty przedstawiają fałszywe informacje jako fakty.

Na początku tego roku Apple zawiesiło w Wielkiej Brytanii swoje narzędzie Apple Intelligence używane do podsumowywania wiadomości.

Stało się to po tym, jak przekazało ono nieprawdziwe treści nagłówków i przedstawiło je jako prawdziwe wiadomości.

Gemini od firmy Google również miał ten sam problem - w zeszłym roku narzędzie AI zasugerowało przyklejanie sera do pizzy za pomocą kleju i stwierdziło, że geolodzy zalecają ludziom zjadanie jednego kamienia dziennie.

Nie jest jasne, co w dużych modelach językowych - technologii, która stanowi podstawę chatbotów - powoduje te anomalie.

„To w rzeczywistości obszar aktywnych badań.

Jak konstruujemy te łańcuchy rozumowania? Jak wyjaśniamy, co tak naprawdę dzieje się w dużym modelu językowym?” - powiedziała Simone Stumpf, profesor odpowiedzialnej i interaktywnej sztucznej inteligencji na Uniwersytecie w Glasgow.

Prof. Stumpf twierdzi, że może to dotyczyć nawet osób, które pracują za kulisami nad tego typu modelami.

„Nawet jeśli jesteś bardziej zaangażowany w rozwój tych systemów, dość często nie wiesz, jak one właściwie działają.

I dlaczego wymyślają te konkretne informacje, które wymyślili” — powiedziała BBC.

ChatGPT zmienił swój model od czasu wyszukiwania pana Holmena w sierpniu 2024 r. i teraz przeszukuje bieżące artykuły informacyjne, gdy szuka odpowiednich danych.

Noyb powiedział BBC, że pan Holmen wykonał tego dnia wiele wyszukiwań, w tym wpisał imię swojego brata do chatbota, a ten wygenerował „wiele różnych historii, które nie były prawdziwe”.

Przyznali również, że poprzednie wyszukiwania mogły wpłynąć na odpowiedź dotyczącą jego dzieci.

Jednak stwierdzili, że duże modele językowe są „czarną skrzynką”, a OpenAI „nie odpowiada na żądania dostępu, co uniemożliwia dowiedzenie się więcej o tym, jakie dokładne dane znajdują się w systemie”.

Dział: Technologia

Autor:

Imran Rahman-Jones | Tłumaczenie: Andrzej Wachnicki - praktykant fundacji: https://fundacjaglosmlodych.org/praktyki/