Deepfake podważa zaufanie społeczne

Czy w przyszłości będziemy mogli ufać tekstom i obrazom?

Badacz Viggo Tellefsen Wivestad w rekordowym czasie przemienił się w Brada Pitta. Ilustracja zapożyczona od badacza.

Technologia Deepfake bywa wykorzystywana do niewinnej rozrywki — ale także do wpływania na wyborców w najpotężniejszych krajach świata. Niedawno gwiazda Hollywood, Brad Pitt, „otworzył” konferencję SINTEF na temat bezpieczeństwa cyfrowego. A raczej nie on sam.

„Skopiowałem jego głos w mniej niż trzy minuty” — przyznaje Viggo Tellefsen Wivestad, badacz z SINTEF Digital.

Wivestad rozpoczął swoje wystąpienie na temat Deepfake od wyświetlenia wideo, w którym występował jako Brad Pitt, z charakterystycznym, zmysłowym głosem:

„Deepfake. Przerażające, prawda?”. I właśnie to jest sednem jego przesłania.

Deepfake stanowi rosnące zagrożenie – dla ciebie jako osoby prywatnej, pracownika, ale także dla całego społeczeństwa. Technologia ta jest jeszcze na wczesnym etapie rozwoju, lecz sztuczna inteligencja otwiera niewyobrażalne możliwości i coraz trudniej wykryć jej zastosowanie.

Słowo „deep” w „Deepfake” pochodzi od „deep learning” – głębokiego uczenia, dziedziny sztucznej inteligencji. W praktyce Deepfake to wszelkie zastosowania AI do tworzenia fałszywych treści multimedialnych. Już teraz widzimy tego liczne przykłady w kampaniach wyborczych w USA. Co istotne — nawet osoby, które samodzielnie tworzą Deepfake’i, przestrzegają przed ich skutkami.

Bardzo wiarygodne oszustwa

„Skopiowanie czyjegoś głosu jest proste, o ile dysponujemy odpowiednim nagraniem. To samo dotyczy zdjęć. Filmy Deepfake są bardziej skomplikowane, ale już teraz możliwe jest tworzenie niezwykle realistycznych fałszywych nagrań” — wyjaśnia Wivestad.

Microsoft opracował technologię, która potrafi wygenerować wideo na podstawie zaledwie jednego zdjęcia. Użytkownik wpisuje, co dana osoba ma powiedzieć, a program sprawia, że jej twarz i usta poruszają się w sposób naturalny.

Zamiana twarzy — więcej niż zabawa

Wielu z nas korzysta z filtrów na Snapchacie, które dodają królicze uszy czy zniekształcają twarz. Ale ta sama technologia może zostać wykorzystana w znacznie mniej zabawny sposób — do podmiany twarzy w zdjęciach i filmach.

W Korei Południowej dużym problemem jest publikowanie pornografii, w której twarze uczniów są podmieniane na wizerunki ich rówieśników. W sześciu na dziesięć przypadków cyberprzemoc dotyka osoby niepełnoletnie.

Podobnych przypadków doświadczyły gwiazdy popu i aktorzy na całym świecie. Istnieje wiele aplikacji oferujących technologię zamiany twarzy. Jeszcze bardziej zaawansowane jest generowanie zarówno głosu, jak i wideo znanej osoby na podstawie samego opisu tekstowego.

Narzędzie w rękach przestępców

Deepfake i sztuczna inteligencja to potężne narzędzia w rękach cyberprzestępców. Wivestad opowiada o przypadku finansisty z Hongkongu, który został oszukany i przelał 25 milionów dolarów po spotkaniu wideo z rzekomym dyrektorem finansowym. Mężczyzna miał wątpliwości, ale rozpoznał kilku współpracowników biorących udział w spotkaniu i dał się przekonać.

Problem polegał na tym, że wszyscy uczestnicy wideokonferencji byli Deepfake’ami. Oszuści sklonowali zarówno twarze, jak i głosy jego współpracowników. Choć była to bardzo wyrafinowana operacja, takie oszustwa będą coraz łatwiejsze dzięki rozwojowi narzędzi cyfrowych. W praktyce można zmusić każdego do powiedzenia czegokolwiek — kiedykolwiek.

Społeczne skutki

„Deepfake może osłabić zaufanie w społeczeństwie” — ostrzega Wivestad.

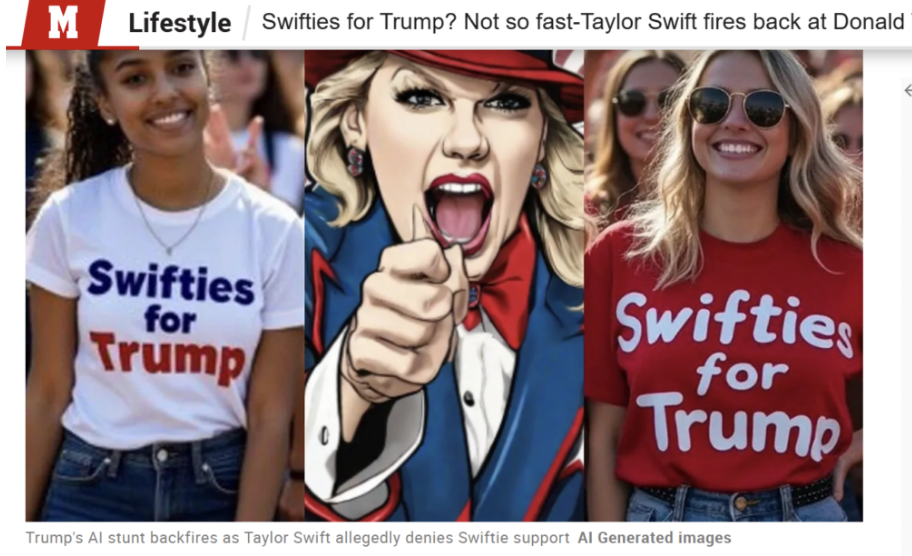

W kampanii prezydenckiej w USA głos Bidena został sklonowany i użyty w automatycznych połączeniach, w których prezydent rzekomo namawiał ludzi, by nie głosowali. Z kolei Donald Trump udostępnił fałszywe zdjęcia sugerujące, że fani Taylor Swift są jego zwolennikami.

Swifties dla Trumpa? Absurd. Zrzut ekranu ze strony internetowej Marca.com

Gdy zaufanie społeczne jest zachwiane, łatwo wzniecać niepewność. Trump twierdził, że zdjęcia z tłumem na wiecu Kamali Harris zostały wygenerowane przez AI — mimo niepodważalnych dowodów, że były prawdziwe.

Mamy też zjawisko tzw. „Liar’s Dividend” — łatwiej jest ludziom twierdzić, że prawdziwe zdarzenia są fałszywe, jeśli nie pasują im do narracji. Przykład? Trump oświadczył na Truth Social:

„Czy ktoś zauważył, że Kamala OSZUKAŁA na lotnisku? Nie było tam nikogo przy samolocie, a ona ‘użyła AI’ i pokazała tłum fikcyjnych zwolenników, KTÓRYCH NIE BYŁO!”.

„Firmy ubezpieczeniowe również odnotowują wzrost liczby sfingowanych szkód w próbach wyłudzeń. A to szczególnie niepokojące, jeśli weźmiemy pod uwagę, że fałszywe wiadomości rozprzestrzeniają się dziesięć razy szybciej niż prawda” — mówi badaczka SINTEF.

Jak wykrywać Deepfake? Kilka wskazówek

Wivestad podaje kilka porad, jak rozpoznać Deepfake — choć zastrzega, że techniki te szybko się dezaktualizują.

• Zwracaj uwagę na szczegóły: liczba palców, kształt przedmiotów — coś może się nie zgadzać.

• Analizuj cienie i odbicia. Fałszerstwa często najłatwiej wykryć w tle.

• Czy znajdujący się na zdjęciu tekst ma sens?

• Czy źródło materiału jest wiarygodne? Jeśli zdjęcie wywołuje silne emocje — może być manipulacją.

„W przypadku głosu mamy w Norwegii pewną przewagę — język norweski to stosunkowo niszowy język, szczególnie z uwzględnieniem dialektów. Dużo łatwiej jest stworzyć Deepfake z głosem Jonasa Gahr Støre’a, mówiącego dialektem z Østlandet, niż Erny Solberg z Bergen” — tłumaczy badacz.

Hasło bezpieczeństwa i zdrowy rozsądek

Jeśli masz wątpliwości, czy rozmawiasz z prawdziwą osobą — warto wcześniej ustalić hasło bezpieczeństwa lub zadać pytanie, na które tylko znajomy zna odpowiedź. Jeśli ktoś wywiera na ciebie presję czasową lub wzbudza silne emocje — zatrzymaj się, przemyśl i zweryfikuj rozmówcę innym kanałem komunikacji.

Nadal można uchronić się przed oszustwem — pod warunkiem, że będziemy rozwijać umiejętność krytycznego myślenia, wiedzę medialną i świadomość zagrożeń online. Nawet jeśli Deepfake’i staną się kiedyś perfekcyjne, mają swoje ograniczenia: oszust nie zna twoich osobistych relacji i historii.

Większość oszustów sama inicjuje kontakt. W razie wątpliwości — zakończ rozmowę i skontaktuj się z daną osobą w zwyczajny sposób. Deepfake nie zastąpi rzeczywistości, dlatego ważne sprawy warto omawiać twarzą w twarz.

Technologiczny wyścig z czasem

Wiedza o zagrożeniach związanych z Deepfake powinna być powszechna — zarówno wśród obywateli, jak i firm, instytucji i władz. Im więcej wiemy, tym łatwiej możemy się bronić — podkreśla Wivestad.

Firmy takie jak Microsoft, Google i OpenAI aktywnie pracują nad rozwiązaniami. Ale trwa wyścig: technologia służąca do wykrywania Deepfake’ów ściga się z tą, która próbuje obejść zabezpieczenia.

Nie narzędzia same w sobie definiują naszą przyszłość, lecz to, jak je wykorzystamy i jak będą regulowane.

– Potrzebujemy zaufanych instytucji, organizacji, dziennikarzy i naukowców. Dla instytutów badawczych, takich jak SINTEF, wiarygodność jest kluczowa. Wierzę, że będziemy ważniejsi niż kiedykolwiek – mówi badacz.

Dział: Telekomunikacja

Autor:

Svein Inge Meland|Tłumaczanie Miłosz Nawrot – praktykant fundacji: https://fundacjaglosmlodych.org/praktyki/

Źródło:

https://gemini.no/2024/11/deepfake-truer-tilliten-i-samfunnet/